Han sido necesarios décadas para que los ingenieros de transmisión y el personal de la sala de control principal acepten las computadoras. En este artículo echaremos un vistazo atrás y veremos cómo se produjo esta aceptación y por qué tardó tanto.

Este documento consta de dos partes. En el primero, observamos las operaciones en las salas de control maestras en los años 80, la llegada de los sistemas de automatización y los dos enfoques distintos del desarrollo inicial de los servidores de video. En el segundo, describimos cuál será la configuración estándar en las salas de control maestras en las próximas décadas, con computadoras totalmente aceptadas como fuentes confiables de video.

El autor de este artículo tiene experiencia de primera mano como cofundador de Vector 3, una de las empresas de automatización más exitosas de la industria. Él, su socio y sus colegas adquirieron su experiencia al proporcionar soluciones informáticas para la industria a lo largo de todo el período histórico de este documento. Como resultado, las soluciones de transmisión de su empresa se probaron, ajustaron y optimizaron exhaustivamente para lograr un funcionamiento fluido y sin errores, y proporcionar un sistema de automatización completo y sólido.

La Era de la Cinta

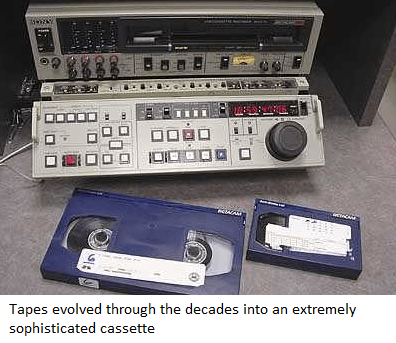

La llegada de la cinta fue un gran avance tecnológico: antes de su invención, las salas de control maestras solo podían operar en vivo. Sin embargo, los carretes abiertos de plástico anchos de los años 50 eran difíciles de manejar y la edición era un trabajo manual minucioso.

Las cintas evolucionaron a lo largo de las décadas hasta convertirse en casetes extremadamente sofisticados, por lo que el antiguo equipo de corte y edición manual que se usaba para las cintas de carrete abierto podría relegarse felizmente al museo. Para acortar una larga historia, a principios de la década de 1980, la cinta de video había sido el rey de las instalaciones de televisión durante 30 años.

Las operaciones y los procedimientos en las salas de control principal en esos días se parecían a una guerra submarina. Varios operadores se sentaron en una mesa larga frente a una pila de monitores, sus dedos en paneles cubiertos con botones de todas las formas, tamaños y colores, realizando su rutina con intercambios verbales rápidos y concisos.

En la galería, como la llamaban sus habitantes, el trabajo del día lo dictaba el flujo de cintas. Temprano en la mañana, llegaba un joven con un carrito del departamento de archivo. El supervisor del turno de la mañana hizo el procedimiento con él. El subalterno llevaba dos listas: las cintas que llegaban para el MCR (las del carrito) y las cintas que debían devolverse al archivo. Vaciaron el carrito, marcando cintas en la primera lista. La segunda parte del procedimiento consistió en llenar el carrito con las cintas que no se necesitaban en el MCR y marcar la segunda lista. Cuando se completó el procedimiento, todos firmaron y se fueron por caminos separados.

Luego, el supervisor verificó la copia impresa de la lista de reproducción y se aseguró de que todas las cintas requeridas para ese día estuvieran en su propio mini archivo o recién entregadas a través del procedimiento de carrito. Con millones de personas viendo exactamente lo que su dedo estaba disparando, el supervisor podría recibir llamadas de sus superiores si las cosas salían mal o, si salían realmente mal, de uno muy alto.

El supervisor verificaría si era posible compilar el contenido de múltiples cintas en una sola cinta (estos eventos consecutivos podrían activarse como un solo bloque). Los supervisores siempre pedían más VTR, ya que cuantos más tenían, más cómodos y seguros podían trabajar sus equipos. Si no se proporcionaran más VTR, los supervisores crearían bloques comerciales compilados. Estos resultaron en una cierta pérdida de calidad, ya que entonces las copias no estaban libres de errores, como lo están en la Era Digital.

The moments before a long non-compiled commercial block in prime time were exhilarating. The supervisor, looking like Captain James T. Kirk, stood behind the operators as they gazed intently at the stack of monitors, while a tense junior waited in the rack room with his hand on a pile of tapes, anxiously reciting Alan Shepard’s prayer. As the millions in the audience listened to the anchor’s cheery “back-in-a-minute”, the gallery supervisor barked battle commands, secretly cursing slower editors who seemed oblivious to the urgency of the control room.

Horas más tarde, en una reunión íntima previa al turno de noche, mientras el público dormía feliz después de una agradable velada frente al palco, los supervisores entrantes y salientes discutían el plan para la madrugada, cuando la transmisión sería lo suficientemente pacífica como para liberar algunos VTR para comprobar las cintas para el personal de archivos. Había pasado un día más, y otra hoja de lista de reproducción fue a la papelera con todas las líneas tachadas.

Cómo eran las cosas en los buenos viejos tiempos…

Un junior entra en la sala de estanterías y carga algunas cintas en una serie de VTR siguiendo las instrucciones escritas a mano de su supervisor de turno. Una vez que se cargan los casetes y los VTR están en modo operativo, el operador del VTR revisa su salida en la pila de monitores. Cada monitor muestra un reloj de tiempo superpuesto al video, un avance relativamente nuevo en ese momento. Una vez que está satisfecho, el operador desconecta los cabezales para que la cinta no se dañe mientras está en espera y le da el visto bueno al supervisor.

Todo el personal espera y observa los LED rojos del reloj de la estación, que está conectado por RF con el Reloj Atómico de Frankfurt, donde un puñado de átomos marca la hora de todo el continente europeo.

Alguien grita la cuenta regresiva, quizás el operador de la batidora, con la mano esperando en la palanca, o quizás el mismo supervisor, si la situación es lo suficientemente crítica: “Diez minutos, cinco minutos, dos minutos, un minuto, 45 segundos, 30 segundos , 15 segundos, 10, 5, 4…”. El operador de VTR engancha las cabezas y empuja el juego. La imagen parpadea en el segundo monitor más central de la pila (PVW) y el operador del mezclador se prepara para abortar en caso de que la cinta se atasque. Pero la imagen se estabiliza y grita “¡arriba!” o «en» o «aire!» o cualquiera que sea la expresión estándar en esa sala de control principal. El técnico de audio en su cabina revisa y ajusta cuidadosamente algunas perillas de aspecto misterioso.

Una transición más exitosa. Un evento más en el aire, marcado en la hoja de la lista de reproducción.

Robots y promesas

La operación al aire las 24 horas del día, los 7 días de la semana, de reproducción de cinta cerrada en la sala de control principal requería tanta gente altamente calificada que, una vez que la tecnología de casete cerrado se estabilizó, parecía claro que se requería algún tipo de automatización industrial. La industria informática hizo algunos intentos de responder a esta necesidad, pero sus soluciones aún dependían de enormes sistemas abiertos de cinta para el archivo a largo plazo. En la industria informática, los casetes cerrados se usaban para operaciones a muy pequeña escala, por lo que no había máquinas de carro de carrete cerrado disponibles que pudieran adaptarse para la transmisión.

En la década de 1980, Sony Corporation lanzó uno de los dispositivos más inspiradores en la historia de la tecnología de los televisores. Se llamó Library Management System (LMS) y se convirtió en un símbolo de estatus entre las estaciones. Aquellos que poseían un LMS pertenecían al grupo élite de locutores de clase mundial.

Un LMS era básicamente un gabinete muy grande con un corredor interno y estantes para cintas a cada lado. En lugar de jóvenes humanos cargando cintas, dos grandes brazos robóticos realizaron la tarea. Por un lado, un recinto del tamaño de una cabina telefónica albergaba una pila de VTR. Los LMS venían en diferentes tamaños, pero el promedio era cinco VTR para 1000 cintas.

Fue increíble ver las manos a la obra, pero más aún cuando entendías lo que estaban haciendo. Al igual que los supervisores de turno humanos, el sistema operativo LMS estaba trabajando en formas de compilar eventos en cinta por adelantado. El Digital Betacam VTR de Sony podía crear copias cuya calidad era, por primera vez, idéntica a la original, lo que permitía compilar bloques sin pérdida de calidad. El software LMS realizó cálculos increíbles por adelantado, como un jugador de ajedrez.

El LMS fue el primer dispositivo en el que la cinta dejó de ser el elemento principal. Secuencias idénticas, denominadas «medios» e identificables con el mismo «ID de medios», se grabaron en cintas diferentes. Existían múltiples copias de cada archivo multimedia, y el software LMS aumentó enormemente la eficiencia de reproducción al copiar, compilar y reproducir bloques optimizados.

Pero el enfoque todo en uno no estuvo exento de problemas. Una galería que presumía de un LMS tendía a ser esclava de él porque la lista de reproducción alimentada a la máquina se convertía de facto en la «lista de reproducción maestra». Los eventos en vivo se consideraban islas pequeñas y no estaba claro si el personal controlaba el LMS durante los bloqueos comerciales o al revés. Los operadores estaban equipados con un botón GPI para decirle al LMS cuándo reanudar la reproducción automática una vez que los humanos terminaron su breve episodio de programación en vivo.

La cuestión de quién estaba a cargo generó muchos enigmas operativos, ya que desapareció la flexibilidad para cambiar los eventos en el último minuto y se impuso la necesidad de flujos de trabajo sistemáticos a personas cuya creatividad había tenido el precio de retrasos legendarios en la entrega de los productos. Poner nuevas cintas dentro de un LMS no fue fácil, ya que estaba ocupado con sus propios procesos lógicos, y persuadir a su software para que operara al límite de su capacidad era un desafío en sí mismo.

Al mismo tiempo que la reproducción se automatizaba cada vez más mediante el uso de máquinas de carro, el proceso de programación también se informatizó. Esto resultó en muchos problemas inicialmente, ya que los primeros programadores no entendían en detalle el funcionamiento de una sala de control maestra. Para empezar, muchos sistemas no calculaban en cuadros sino en segundos. Esto probablemente no parecía ser un problema para los fanáticos de las computadoras, pero para los supervisores de las galerías era una pesadilla. Los programas se editaron redondeando los tiempos a medio segundo, cuyo resultado acumulativo fue que los horarios podían atrasarse 10 o más segundos después de varias horas de reproducción. Muchas estaciones tenían un proceso llamado “tráfico” que, entre otras cosas, ajustaba una lista de reproducción dada en segundos redondos a fotogramas. Las listas de reproducción generadas por computadora representaron el primer contacto del personal de la sala de control principal con las computadoras y, en particular, para los supervisores de la galería, no fue una experiencia agradable.

With all its marvellous technology and its super-high-quality performance, the LMS was extremely expensive. The complexity of its setup and its arcane configuration settings meant the price of ownership was too high for even those TV stations used to paying three shifts of eight well-paid staff.

Odetix lanzó un dispositivo mucho más simple. Sony respondió con Flexicart, Panasonic con SmartCart y Thomson con Procart. Estas máquinas de carro de nueva generación eran mucho más pequeñas y la idea era alimentarlas diariamente con las cintas requeridas. Se propusieron dos enfoques para manejar la gestión en el aire. El modelo tradicional requería que las máquinas de carro funcionaran con su propio enrutador controlado remotamente por su propio software, como solía hacer el LMS. Entregarían una señal sobre la cual el supervisor no tenía control (al igual que cuando el MCR pasó la señal a un estudio en vivo). Con el segundo enfoque, los robots se utilizaron como telemanipuladores. El operador de VTR podía controlar cada VTR y el brazo robótico de forma remota desde su mesa, lo que le permitía seleccionar uno y enviar una señal al mezclador de la sala de control principal. Si fuera necesario compilar bloques comerciales, el personal de la sala de control lo gestionaría manualmente.

Los supervisores de turno estaban fuertemente a favor de la segunda opción, que les devolvía el control. Pero una tercera configuración, aún más alarmante, finalmente tuvo éxito. Los departamentos de ingeniería propusieron que las computadoras controlen no solo el enrutador VTR sino también el mezclador principal del MCR. Argumentaron que una computadora podría posicionar las VTR, hacer el pre-roll, controlar el mezclador y desencadenar eventos con mayor precisión que la mano humana.

En la práctica, sin embargo, esto fue más complejo de lo que habían previsto los videntes. Toda una generación de operadores vio cómo las torpes computadoras causaban estragos. Ciertas máquinas carretas se hicieron famosas por su estupidez y era común un síndrome tipo “oso polar en el zoológico”, en el que realizaban la misma acción repetidamente, como poner la cinta en el VTR y sacarla una y otra vez, hasta que el supervisor finalmente desconectó y reinició la máquina. Los espectadores en casa verían rebobinados repentinos, sin darse cuenta de que se trataba de un desafortunado efecto secundario de los primeros intentos de automatización.

Pero a medida que los algoritmos y la calidad del software mejoraron rápidamente, la precisión del tiempo volvió a estar donde había estado durante décadas: en algún lugar entre cero y un cuadro, y las salas de control maestras automatizadas se convirtieron en la norma. Una nueva generación de programadores de software familiarizados con las operaciones de la galería hizo la mayor parte del trabajo y los ingenieros de transmisión reemplazaron a los ingenieros informáticos en la planificación de la automatización de la sala de control principal.

Los equipos desconfiados de la galería generalmente hacían y mantenían un registro del verdadero «SOM» (comienzo del mensaje: el punto en una cinta cuando comenzaba un programa) que normalmente no compartían con el resto de la instalación. Se crearon islas informáticas para separar el MCR del caos del resto de la estación de televisión.

La vida podría haber continuado de esta manera, pero la industria informática había hecho una nueva promesa a los dueños de las estaciones: el video podría convertirse en un archivo de computadora y reproducirse tan fácilmente como una impresora imprime una lista de reproducción. Los gerentes de las estaciones estaban ansiosos por probarlo y entusiasmados con la posibilidad de no necesitar más los costosos procedimientos de limpieza de cabezales de VTR que se requieren para las cintas de video.

Entonces, a mediados de los 90, la era de la cinta parecía haber terminado. Los supervisores de turno, que primero se molestaron por la falta de marcos en las listas de reproducción generadas por computadora de los años 70 y luego se sorprendieron por la inflexibilidad de la primera generación de software de automatización en los años 80, debían enfrentar nuevos y mayores horrores con el siguiente paso. en la revolución Llevaría otros 10 años completarlo y, perversamente, las estaciones más ricas serían las que más sufrirían.

Standard behemoths vs. dedicated dwarfs

Ahora, con la revolución completa, es difícil recordar la emoción del mercado de la transmisión a mediados de los 90. La unión de las computadoras y el video superó todas las expectativas una vez que la tecnología original (seleccionar el color de cada punto en el monitor cambiando los valores en un búfer de memoria asociado) fue respaldada por un software de bajo nivel sobre el cual se podían construir aplicaciones útiles.

Cada IBC presentó al visitante algo más que una selección de nuevos productos; ahora ofrecía mercados completamente nuevos a las emisoras. Como suele suceder durante los períodos de rápido desarrollo tecnológico, todo parecía posible y las empresas tenían dificultades para decidir cuál de los inventos de sus equipos impulsar como su producto estrella.

En poco tiempo, los grandes nombres de la industria informática, que ya prestaban servicios a los grandes nombres de la industria de la radiodifusión, vieron un nuevo nicho que explotar: la sala de control maestra.

Los departamentos de sistemas de las corporaciones de radiodifusión estaban en ese momento ocupados informatizando el archivo de cintas y el flujo de trabajo, incluida la creación de listas de reproducción, bloques comerciales automatizados y gestión de derechos.

La idea era que una vez que hubieras muestreado el video cuadro por cuadro, se convirtiera en “un conjunto de 1 y 0” que pudieras almacenar y administrar como un archivo de computadora. Las matemáticas se explicaron en servilletas de papel a muchas personas nuevas en la tecnología: 576 líneas x 720 columnas hicieron un total de casi medio millón de puntos o «píxeles».

Cada “píxel” debe contener información suficiente para especificar un color y, como los informáticos se explicaron una y otra vez, el ojo humano tiene una percepción muy fina del color: podemos distinguir varios millones de colores diferentes. La primera potencia de dos (1s y 0s) que permite combinaciones suficientes para hacer esto es 8 (28 = 256). 256 elevado a 3 (los 3 colores que emiten los tubos) da más de 16 millones de colores, superando la capacidad humana de diferenciación.

Las matemáticas finales consisten en multiplicar el medio millón de puntos por esta información sobre los 3 colores para averiguar qué tan grande es un solo cuadro y luego multiplicar el resultado por 25 cuadros por segundo para encontrar el tamaño en disco de un segundo de video de calidad de transmisión.

Mucho más tarde se descubrió que la necesidad de bytes no era tan grande y que había múltiples soluciones que ahorrarían espacio. En ese momento, sin embargo, el espejismo de los archivos enormes marcó el comienzo de la era de los gigantes de TI. La microcomputación había estado erosionando el mercado de las minicomputadoras y el sector de la transmisión parecía muy prometedor, un sector en el que solo los procesadores de bits realmente a gran escala podían competir. Reemplazar un LMS con una computadora grande fue rentable y no parecía demasiado difícil.

A lo largo de los años, los principales fabricantes de computadoras ofrecieron monstruos cada vez más grandes con inmensas capacidades de almacenamiento y anchos de banda. La idea era que todo el video fluyera como archivos dentro de la estación. Debido a que las tasas de transferencia eran tan lentas, la solución obvia era crear un depósito de almacenamiento central donde se pudiera acceder a todos los archivos de video desde las estaciones de trabajo para editarlos o reproducirlos.

Desde la perspectiva actual, estos gigantescos sistemas se asemejan a esos aviones de formas extrañas que se ven estrellarse en los documentales sobre los comienzos del vuelo humano. Pero en ese momento parecían soluciones reales y viables. Algunos de ellos eran realmente sofisticados y, una vez que se entendieron los principales problemas (que las tasas de bits de las computadoras no son constantes, sino que suben y bajan, mientras que el video requiere una tasa de bits constante y sostenida) los productos comenzaron a evolucionar.

Esta evolución no duró mucho. Una vez que se entendió la magnitud del trabajo de rediseño requerido para garantizar una “tasa de bits sostenida”, el trabajo de desarrollo se detuvo y la mayoría de los productos de este tipo fueron descontinuados. Los requisitos técnicos de la industria de la radiodifusión exigían una inversión en investigación que las ventas potenciales no podían justificar. Si las tecnologías de TI estándar disponibles en ese momento no funcionaban (y ciertamente no lo hicieron), el mercado no era rentable. Entonces, uno por uno, los fabricantes de computadoras se retiraron.

Mientras que los fabricantes de computadoras, trabajando en estrecha colaboración con los departamentos de sistemas de las corporaciones de transmisión, se estaban dando cuenta de lo complejo que era este mercado, los fabricantes de video tradicionales estaban siguiendo otro camino. Sabían desde el principio que se necesitaban tasas de bits sostenidas y que los controladores de disco eran la clave. Desarrollaron con éxito controladores de disco y lograron crear sistemas capaces de grabar y reproducir, con pequeños búferes para lograr una salida con precisión de cuadro.

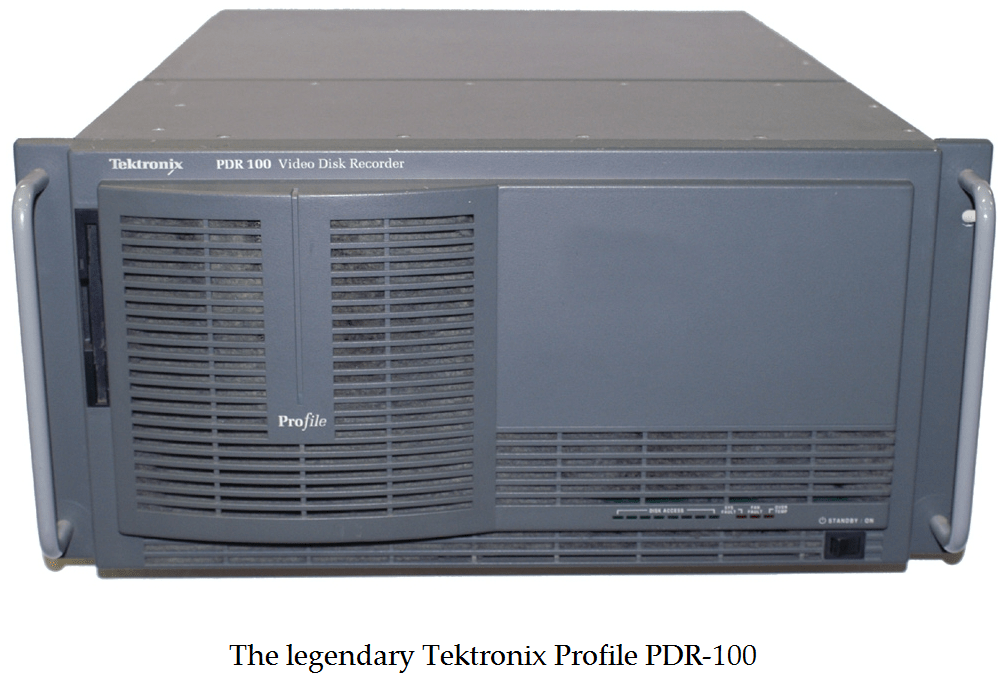

Al ser empresas de video tradicionales, no tenían los recursos para desarrollar un sistema capaz de reproducir más de dos o tres canales o con una gran cantidad de almacenamiento. Además, debido a que la tecnología se desarrolló con este único propósito, era incompatible con cualquier otra tecnología informática. Estos productos, y particularmente el más exitoso de ellos, Tektronix Profile, eran confiables y estaban dirigidos a un público más humilde que los productos de sus contrapartes fabricantes de computadoras. En lugar de informatizar todo el flujo de trabajo de la estación, solo tenían como objetivo reemplazar los VTR y solo los que se usaban específicamente para la reproducción.

Los equipos comerciales de las grandes empresas informáticas de primer nivel se habían quemado los dedos por una serie de dolorosos y costosos fiascos y, como resultado, los «enanos» (y lo que se conoció como «servidores de video») llegaron a dominar el mercado y apoderarse de la red. salas de estanterías.

La clave inicial del éxito de estos sistemas residía en la simplicidad de su diseño, pero a la larga esto significó su desaparición. A medida que la edición no lineal o por computadora se hizo más popular, quedó claro que volver a la «banda base» antes de cargar en el servidor de videos no era una buena idea. Entonces, a lo largo de los años, los fabricantes de servidores de video intentaron conectarlos a NLE y otros servidores de video para crear sistemas más grandes. Sin embargo, esto no fue sencillo, y la combinación de máquina de carrito y servidor de video en modo caché siguió siendo la más popular entre los ingenieros de transmisión.

Una de las tecnologías que contribuyó al éxito de estos enanos patentados fue la compresión de video, que redujo la necesidad de almacenamiento y ancho de banda, considerados necesarios en los primeros días de la computación de video, a una fracción manejable. Pero la desventaja fue que la compresión trajo de vuelta el problema de la degradación de la copia que el video digital había eliminado de la tecnología de cinta. La copia de video de un disco a otro mediante la descompresión a SDI y luego la recompresión resultó en una reducción de la calidad conocida como concatenación. En un entorno de TI, los archivos se pueden copiar directamente sin compresión y sin pérdida de calidad.

La demanda del mercado de compatibilidad comenzó a aumentar. Había dos obstáculos principales para el avance de los estándares que habrían permitido el intercambio de archivos sin concatenación. En primer lugar, estaban las barreras técnicas inherentes: los servidores de video de hardware no estándar usaban sistemas operativos especialmente desarrollados y controladores inventados sobre la marcha, por lo que construir componentes como controladores compatibles con SMB desde cero no era simple. La mayoría de los fabricantes recurrían a emuladores de FTP que hacían posible el acceso a los archivos pero lento y rudimentario.

El segundo obstáculo era comercial. Los comités de la industria celebraron reuniones continuas que no llegaron a ninguna parte porque los grandes nombres realmente no querían estándares. Cada uno soñaba con un mercado de transmisión completamente dominado por su propia marca. Años de discusión condujeron solo al concepto de «envoltura», y después de casi otra década se acordó una envoltura semi-común: el MXF. Los ingenieros de radiodifusión no presionaron mucho por la integración, ya que estaban familiarizados con la concatenación, que era similar a la degradación de la copia de la era analógica, y en ese momento habían desarrollado cierta fobia a la integración multimarca basada en pseudo-estándares que nadie. podría hacer cumplir.

Hoy en día solo existen unos pocos de estos sistemas, y la presión para que se conviertan en computadoras se ha vuelto irresistible. Intercambiar archivos con terceros se ha vuelto tan importante como reproducirlos o grabarlos. La revolución ha terminado, y una sala de control maestra basada en TI con calidad de transmisión y confiabilidad de transmisión no solo es posible, sino que se ha convertido en la norma. Y así como los aviones a reacción de hoy son muy similares a los de los años 60, el aspecto actual de las salas de control maestras multicanal basadas en TI probablemente sobrevivirá tanto como la propia industria de la transmisión.